数据处理作为现代信息技术的基础环节,其源码实现质量直接决定了数据系统的可靠性与效率。一个完整的数据处理流程通常包含数据采集、清洗、转换、存储和分析等核心模块,每个模块的源码设计都有其独特的技术考量。

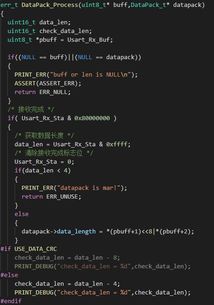

在数据采集阶段,源码需要实现多源适配能力,支持从数据库、API接口、文件系统(如CSV、JSON)及实时流数据中高效提取信息。常见的开源实现如Apache Flume和Logstash,其源码中大量运用了生产者-消费者模式和异步IO机制,确保在高并发场景下的稳定采集。

数据清洗模块的源码则聚焦于异常值处理、缺失值填充和格式标准化。例如Pandas库的DataFrame.dropna()方法源码,通过向量化操作和布尔索引实现高效过滤;而正则表达式引擎在文本清洗中的深度优化,展示了模式匹配算法的精妙设计。

转换阶段源码常体现为ETL(抽取-转换-加载)流水线设计。Spark SQL的Catalyst优化器源码是典型代表,它通过抽象语法树(AST)转换和谓词下推等技术,将声明式查询转化为最优执行计划。这种编译式处理相比传统解释执行,性能可提升数倍。

存储模块的源码设计需要平衡读写效率与存储成本。HBase的LSM树实现源码展示了如何通过内存MemTable与磁盘SSTable的协同,实现高吞吐写入;而列式存储库如Apache Parquet的源码中,使用字典编码和游程压缩算法,使存储空间减少60%以上。

分析处理源码最体现算法功力。从单机的NumPy广播机制源码,到分布式的MapReduce实现,都蕴含着对计算资源的极致利用。近年来出现的向量化执行引擎(如ClickHouse),其源码通过SIMD指令级并行和缓存友好型数据结构,将分析性能推向新高度。

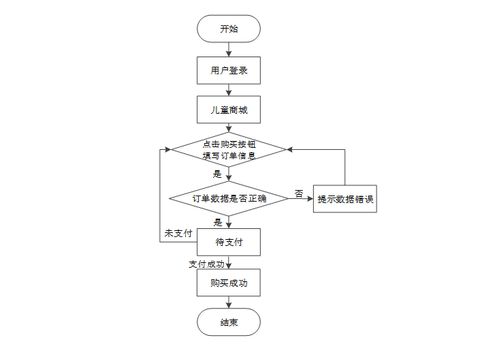

优秀的数据处理源码往往具备三大特征:一是模块化设计,如Apache Beam提出的统一数据处理模型;二是容错机制,包括检查点(Checkpoint)和 lineage 回溯;三是可观测性,通过埋点指标暴露内部状态。这些设计思想在Flink、Kafka Streams等开源项目源码中得到充分体现。

值得关注的是,现代数据处理源码正呈现两大趋势:一是计算存储分离架构下的弹性设计,如Snowflake的虚拟仓库调度源码;二是AI增强的数据处理,如通过机器学习自动优化连接顺序的数据库系统。这些创新正在重新定义数据处理源码的技术边界。

深入研读优秀的数据处理源码,不仅能掌握具体实现技术,更能理解数据流动的本质规律。从经典的归并排序算法实现,到最新的流批一体架构,每一行代码都是对数据价值挖掘方法论的技术具现。这要求开发者既要有扎实的算法数据结构基础,又要具备系统思维,方能在数据洪流中构建稳固可靠的处理管道。